Für BMS-, BUS-, Industrie- und Instrumentierungskabel.

Vorausschauende Wartung von Geräten

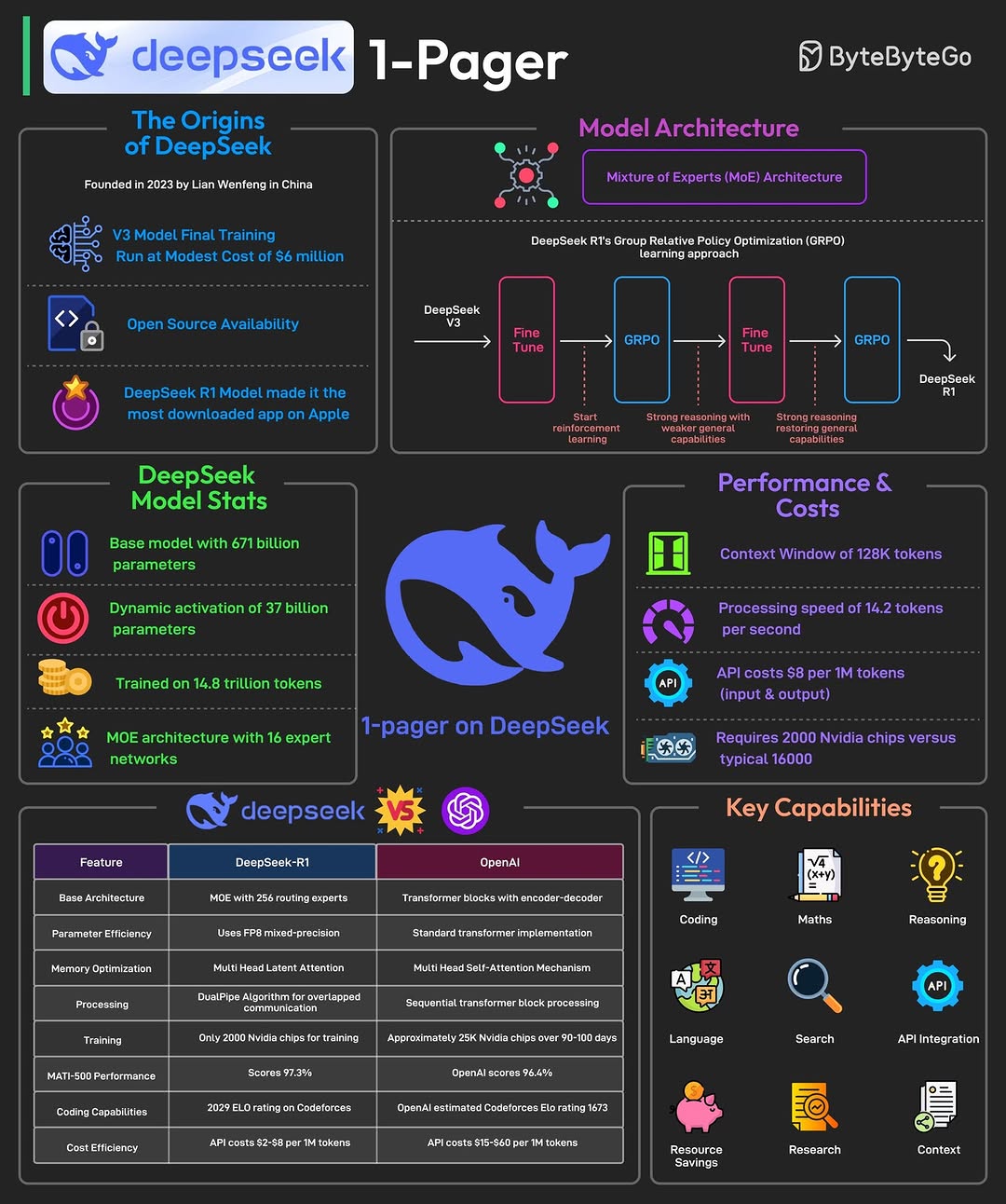

Technische Umsetzung

Relevanter Fall

Schneider Electric setzte diese Lösung auf Bergbaumaschinen ein und reduzierte dadurch die Falsch-Positiv-Rate um 63 % und die Wartungskosten um 41 %.

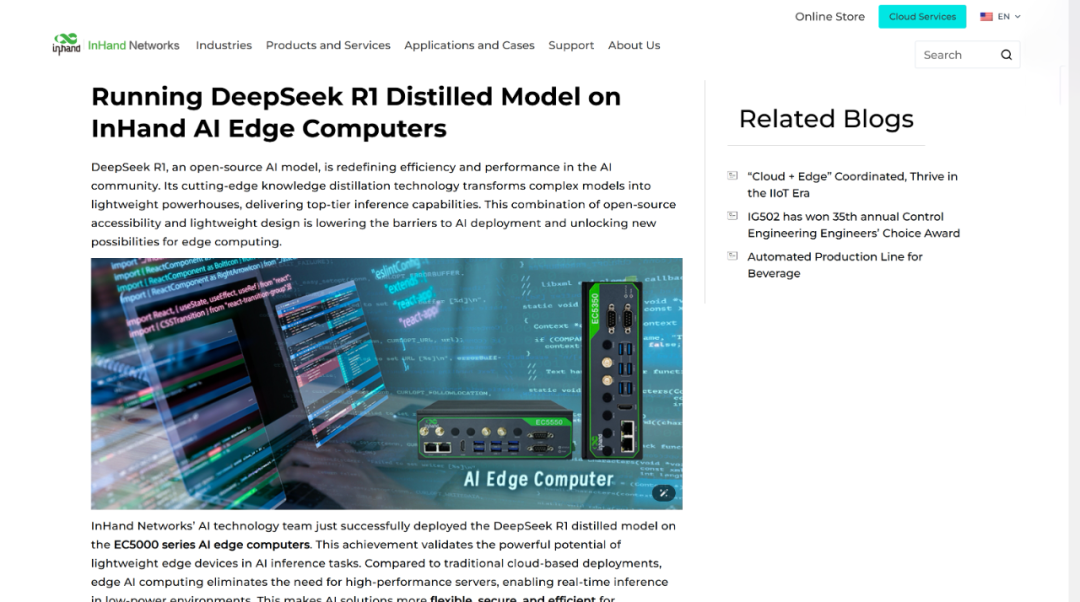

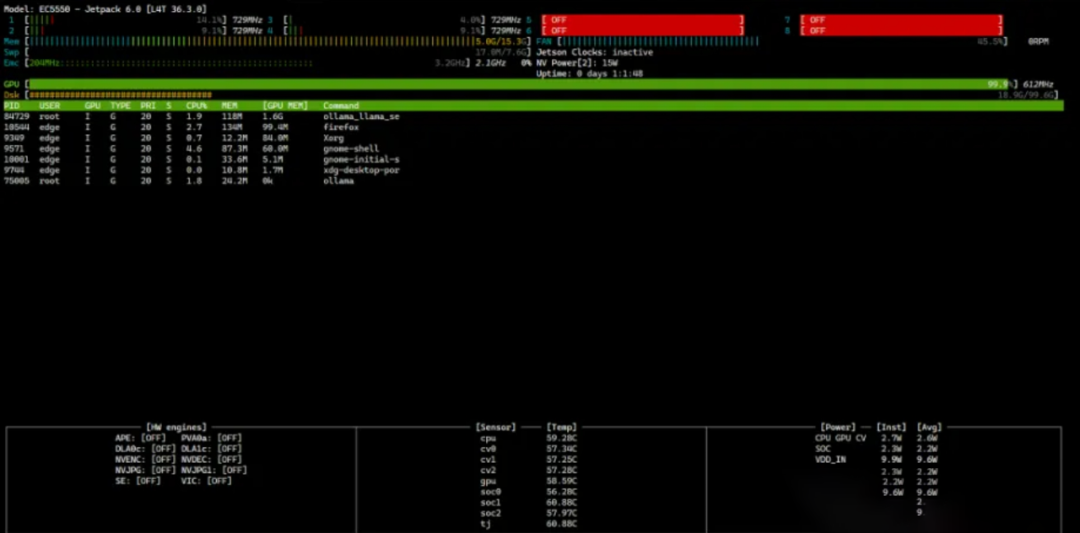

Ausführen des DeepSeek R1-Destillationsmodells auf InHand AI Edge-Computern

Verbesserte Sichtprüfung

Ausgabearchitektur

Leistungsmetriken

Die Auswirkungen von DeepSeek R1: Gewinner und Verlierer in der generativen KI-Wertschöpfungskette

Prozessablaufoptimierung

Schlüsseltechnologien

Implementierungseffekt

Das Chemiewerk der BASF führte dieses System ein und erzielte dadurch eine Senkung des Energieverbrauchs um 17 % und eine Verbesserung der Produktqualität um 9 %.

Edge-KI und die Zukunft der Wirtschaft: OpenAI o1 vs. DeepSeek R1 für Gesundheitswesen, Automobilindustrie und IIoT

Sofortiger Abruf der Wissensdatenbank

Architekturdesign

Typischer Fall

Die Ingenieure von Siemens lösten Wechselrichterfehler durch Abfragen in natürlicher Sprache und reduzierten so die durchschnittliche Verarbeitungszeit um 58 %.

Herausforderungen und Lösungen bei der Bereitstellung

Abschluss

Die aktuellen Bereitstellungskosten sind inzwischen auf 599 US-Dollar pro Knoten (Jetson Orin NX) gesunken, und skalierbare Anwendungen entstehen in Branchen wie der 3C-Fertigung, der Automobilmontage und der Energiechemie. Durch die kontinuierliche Optimierung der MoE-Architektur und der Quantisierungstechnologie soll das 70B-Modell bis Ende 2025 auf Edge-Geräten lauffähig sein.

Steuerkabel

Strukturiertes Verkabelungssystem

Netzwerk und Daten, Glasfaserkabel, Patchkabel, Module, Frontplatte

16.-18. April 2024 Middle-East-Energy in Dubai

16.-18. April 2024 Securika in Moskau

9. Mai 2024: Launch-Event für neue Produkte und Technologien in Shanghai

22.-25.10.2024 SECURITY CHINA in Peking

19.–20. November 2024 CONNECTED WORLD KSA

Beitragszeit: 07.02.2025